昨今LLM(Large Language Model)が大きな注目を集める一方で、パラメータ数がどのように決まるかについて抑えておくと理解に役立ちます。そこで当記事ではLLMの主要モジュールであるTransformerに用いられるパラメータの概算法について取りまとめを行いました。Transformerの論文 や筆者作成の『直感的に理解するTransformer 』の内容などを元に取りまとめを行いました。

・用語/公式解説https://www.hello-statisticians.com/explain-terms

・Transformer論文 ・直感的に理解するTransformer(運営者作成)

パラメータ数の概算 パラメータ数の単位 LLM(Large Language Model)関連の論文ではパラメータ数はMillionを表すMやBillionを表すBで略記されるので注意が必要です。Millionは$10^{6}$の$100$万、Billionは$10^{9}$の$10$億にそれぞれ対応します。

具体的な論文とパラメータ数の対応については、$110$Mと$340$MのBERTが$1.1$億と$3.4$億、$11$BのT$5$が$110$億、$175$BのGPT$3$が$1750$億にそれぞれ対応します。

Transformerの大まかな仕組み LLMの基盤のアーキテクチャには基本的にTransformerが用いられます。よって、LLMのパラメータ数について解釈する際はTransformerの大まかな仕組みの理解が重要です。Transformerの大まかな仕組みについては下記で詳しくまとめました。

・直感的に理解するTransformer

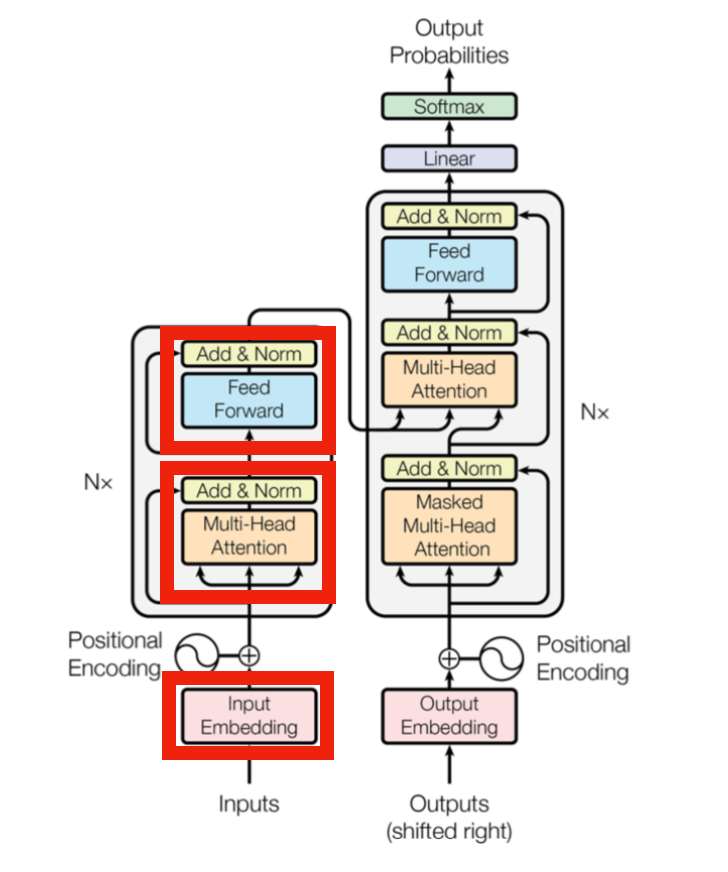

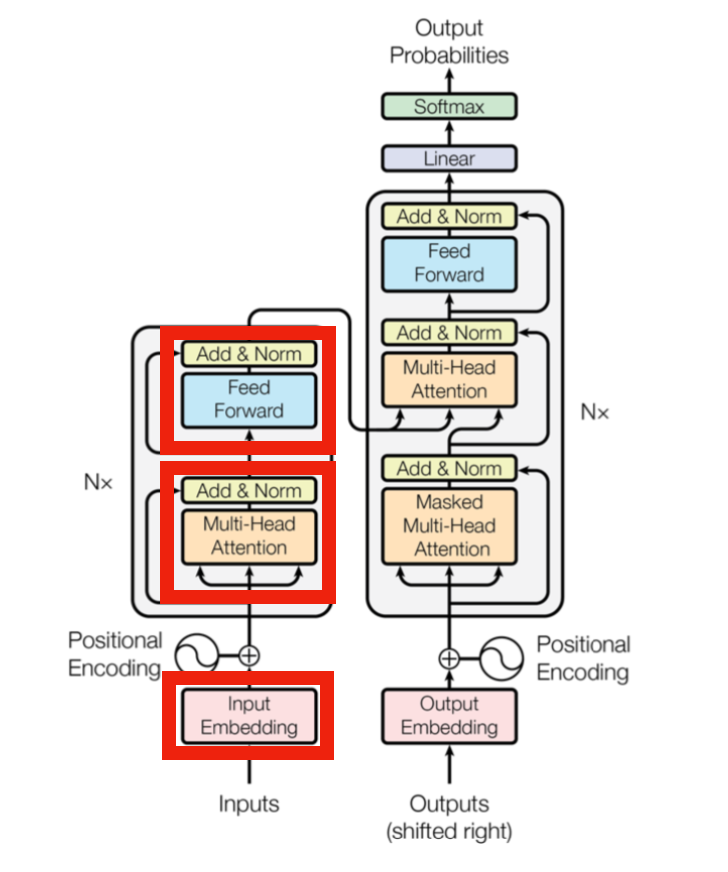

パラメータ数の概算 Transformerにおけるパラメータは主にEmbedding、各層におけるMulti-Head Attention、FFN(Feed Forward Network)処理にそれぞれ用いられます。下図の赤枠がパラメータ処理に対応します。

Transformer論文のFigure$1$を改変 上記に基づいてTransformerに用いられるパラメータ数を大まかに概算することが可能です。以下、パラメータ数の計算を下記の三つにわけて概算します。

$1. \,$ Embedding処理

Embedding処理

Embedding処理は$1$-hotベクトルにEmbedding Matrixを左からかけることで得ることができます。このEmbedding Matrixのパラメータ数は語彙数$V$とTransformer処理における隠れ層の数$D$によって概算が可能です。

たとえば$1$万種類の単語に対し、Transformerのそれぞれの単語の隠れ層の数が$D=512$である場合、パラメータ数は下記のように概算できます。

上記は約$5$Mに対応します。同様に$10$万種類の単語を$D=1024$で取り扱う場合は下記のように概算できます。

上記は約$100$Mに対応します。パラメータ数の概算にあたっては、桁数で大まかに把握できるので、$5.12 \times 10^{6}$や$1.024 \times 10^{8}$のようにパラメータ数を表しました。

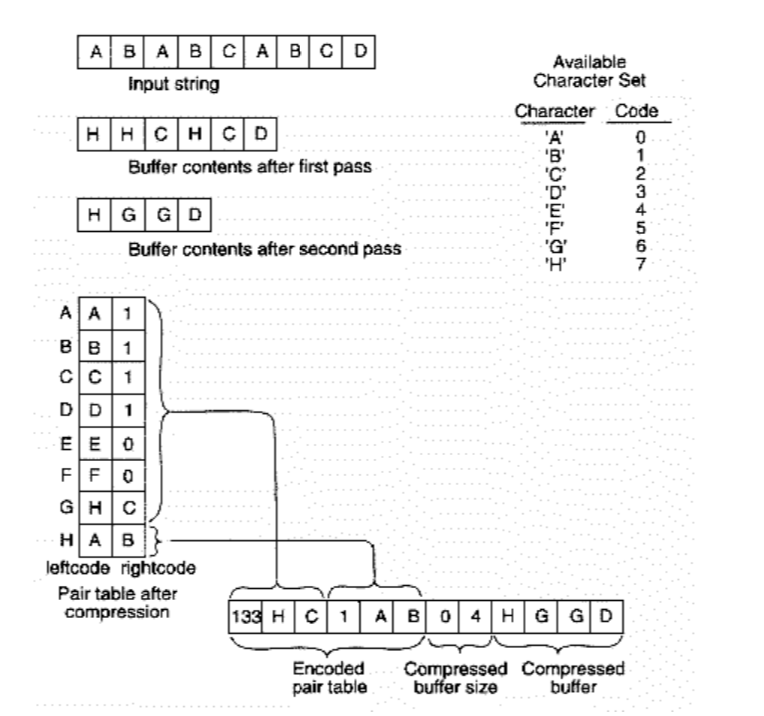

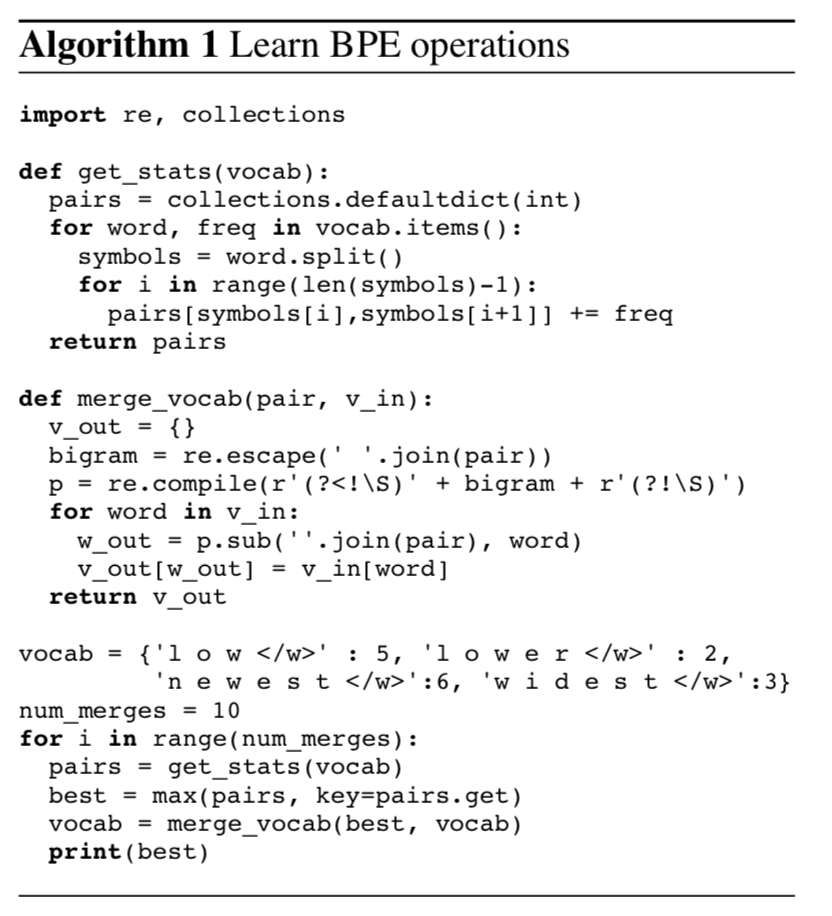

トークンが単語単位の場合はWord$2$vecがEmbeddingに対応する一方で、トークンの種類が増大するLLMではBPE(Byte Pair Encoding)などを用いることで$3$万〜$7$万種程度の語彙(vocabulary)に集約させるのが一般的です。よって、LLMの学習時に取り扱う文章が増えても語彙数は数万程度に収まることが多いです。

Multi-Head Attention処理

$$

Multi-Head Attentionではアンサンブル学習と同様に各Headにおける計算の相関が低くなるようにパラメータ$W$を元に上記のような計算を行います。ここで$d_{model}$は各トークンの分散表現の次元数であり前項 の$D$と同義です。また、$h$はヘッドの数を表します。このとき、パラメータ数は下記のように概算できます。

$N=6, d_{model}=512, h=8, d_{k}=64, d_{v}=64$のとき、Multi-Head Attention処理のパラメータ数は$(1)$式を元に下記のように概算できます。

上記は$6.29$Mに対応します。

FFN処理

FFN処理は単語ごとの隠れ層に対してMLP(Multi Layer Perceptron)を行うことに対応します。よって、単語数$L$、それぞれの単語の隠れ層の数が$D$である場合、$N$層のMLPにおけるパラメータ数は下記のように概算することができます。

たとえば、$N=6, L=512, D=512$の場合、パラメータ数は下記のように概算できます。

上記は$800$Mに対応し、Transformerのパラメータ数の約$100$Mを大きく上回ります。Transformerでは一般的に同じ層の単語では同じパラメータを使うので、$L$はかけないことに注意が必要です。また、FFNの処理では「$D$次元$\to$$D$次元」ではなく、「$D$次元$\to$$4D$次元$\to$$D$次元」のような処理が行われます。中間層の$4D$は別途設定されることもありますが、$4D$が用いられることが多いです。ここまでの内容に基づいてFFN処理におけるパラメータは下記のように概算できます。

また、$N=6, D=512$の場合のパラメータ数は$(2)$式より下記のように概算できます。

上記は$12.6$Mに対応します。

LLMのパラメータ数の概算 注意事項:Encoder-Decoderの場合 Transformer論文のFigure$1$を改変 前節 では上図を元にEncoder部分のみを確認しましたが、論文によってEncoderとDecoderの双方を用いる場合があることに注意が必要です。この場合、Multi-Head Attentionのパラメータ数を$3$倍、FFNの処理のパラメータ数を$2$倍して概算する必要があります。

具体的にはTransformerの論文やT$5$の論文はEncoderとDecoderを用いており、BERTやGPT-$3$は片方のみが用いられます。

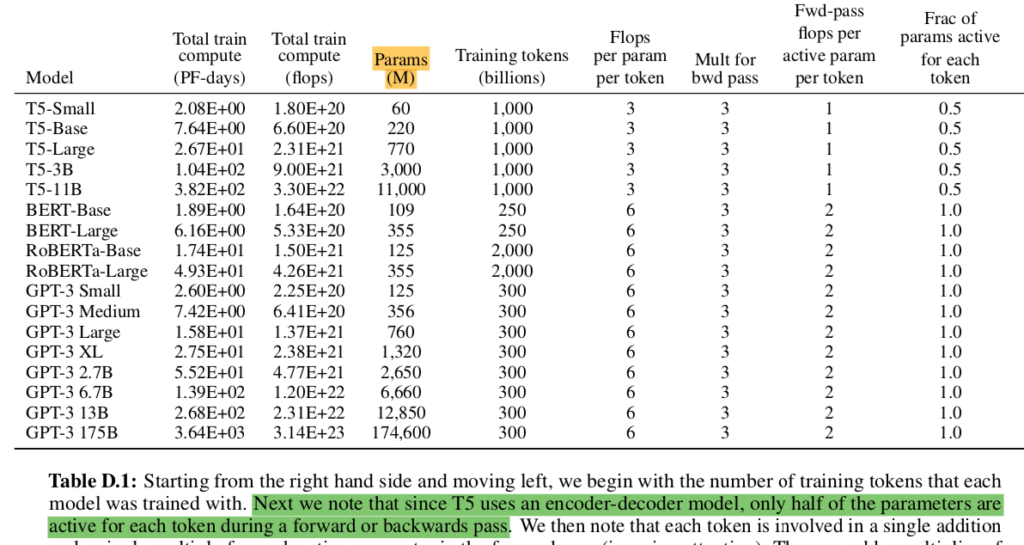

GPT-$3$論文のTable$D.1$より 上記はGPT-$3$の論文のTable$D.1$に対応しますが、「T$5$がencoder-decoder modelであるのでパラメータの半数のみがactive」というような注意書きが読み取れます。

このように論文毎にパラメータの概算方法が変わる場合があるので単にパラメータの総数だけでなく、大まかな概算法も合わせて抑えておくと良いです。

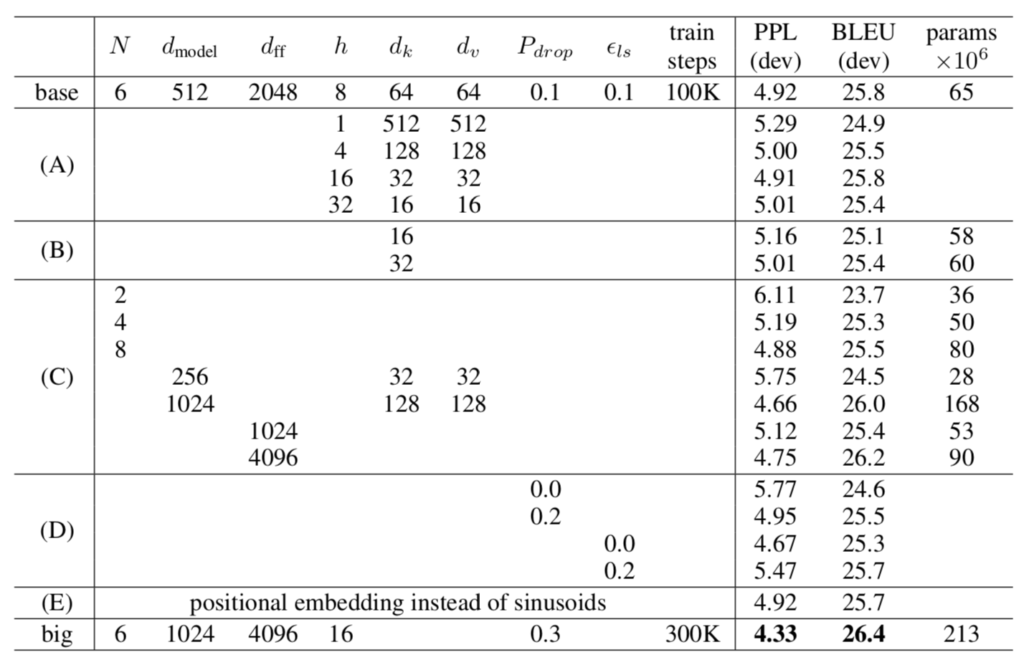

Transformer Transformer論文のTable$3$より Transformer論文のパラメータ設定は上記より確認できます。以下、Transformerのパラメータ数がEncoder-Decoderを前提に計算されることを元にbaseとbigの双方についてパラメータの概算を行います。

base

・Embedding

・Multi-Head Attention

・FFN

よって、パラメータの総数は下記のように概算できます。

上記は$63$Mなので、表の値と概ね一致することが確認できます。

big

・Embedding

・Multi-Head Attention

・FFN

よって、パラメータの総数は下記のように概算できます。

上記は$214$Mなので、表の値と概ね一致することが確認できます。

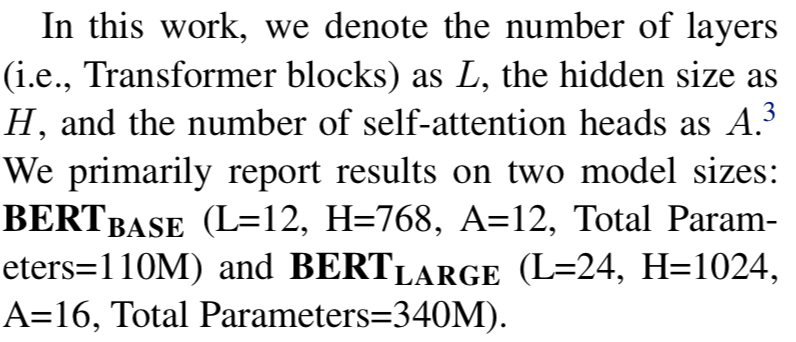

BERT BERT論文のSection$3$より BERT論文のパラメータ設定は上記より確認できます。以下、BERTのパラメータ数がEncoderのみを用いて計算されることを元にBASEとLARGEの双方についてパラメータの概算を行います。

BASE

・Embedding

・Multi-Head Attention

・FFN

よって、パラメータの総数は下記のように概算できます。

上記は$108$Mなので、論文のパラメータ数と概ね一致することが確認できます。

LARGE

・Embedding

・Multi-Head Attention

・FFN

よって、パラメータの総数は下記のように概算できます。

上記は$333$Mなので、論文のパラメータ数と概ね一致することが確認できます。

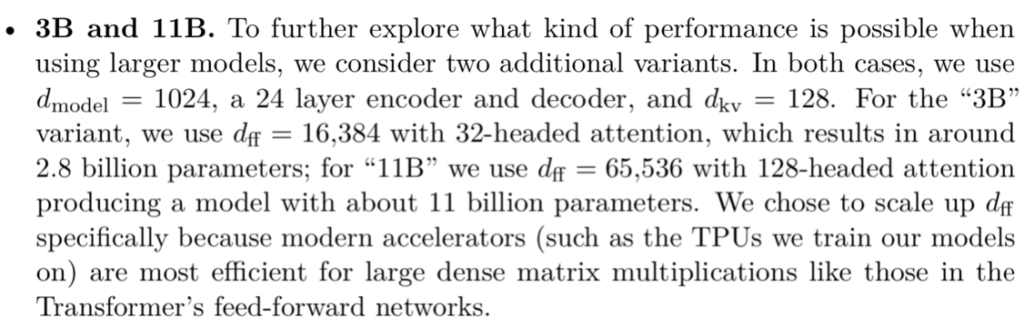

T$5$ T$5$論文のSection$3.7$より T$5$論文のパラメータ設定は上記より確認できます。以下、T$5$のパラメータ数がEncoder-Decoderを前提に計算されることを元に$3B$と$11B$の双方についてパラメータの概算を行います。

$3B$

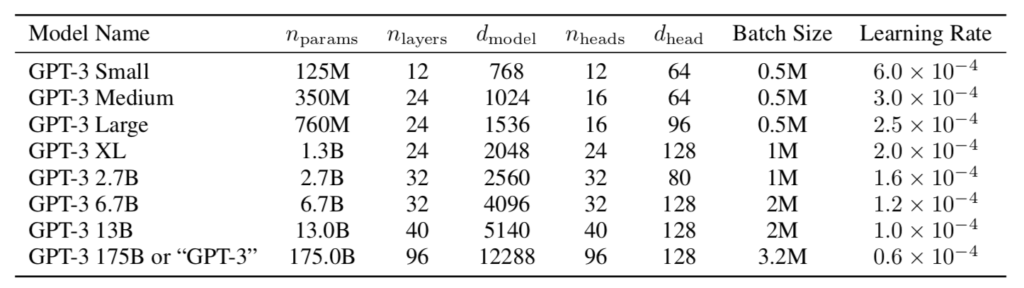

GPT-$3$ GPT-$3$論文のTable$2.1$より GPT-$3$のパラメータ設定は上記より確認できます。

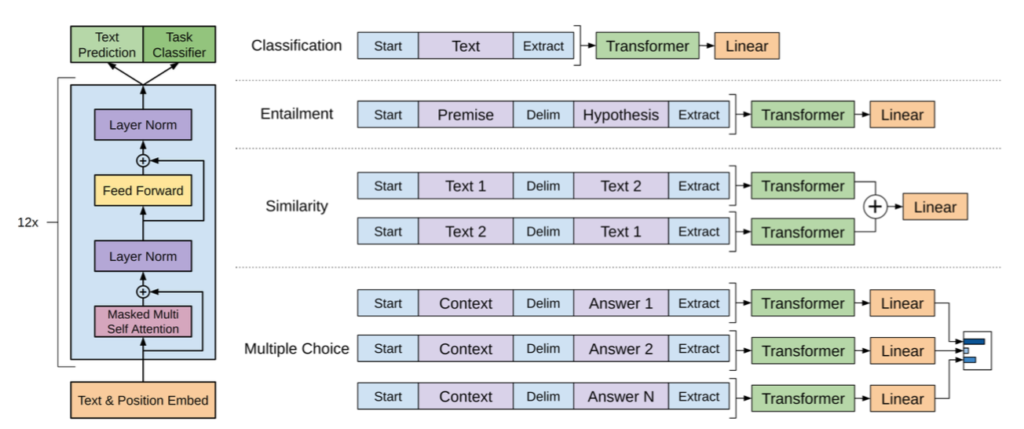

GPT論文のFigure$1$より GPT-$3$では上図のようにencoderを用いないTransformerであるTransformer decoder を用います。Transformer decoderの概要については下記で詳しく取り扱いました。

GPT論文のFigure$1$よりGPT-$3$のパラメータ数はencoderのみを用いるBERTと基本的には同様の概算を行えることが確認できます。以下、GPT-$3$のパラメータ数がEncoderのみを用いて計算されることを元に$6.7$B、$13$B、$175$Bについてパラメータの概算を行います。

$6.7$B

・Embedding

$V=40000$はGPTの論文を参照しました。

・Multi-Head Attention

・FFN

よって、パラメータの総数は下記のように概算できます。

上記は$6.6$Bなので、表の値と概ね一致することが確認できます。

$13$B

・Embedding

$V=40000$はGPTの論文を参照しました。

・Multi-Head Attention

・FFN

よって、パラメータの総数は下記のように概算できます。

上記は$12.9$Bなので、表の値と概ね一致することが確認できます。

$175$B

・Embedding

$V=40000$はGPTの論文を参照しました。

・Multi-Head Attention

・FFN

よって、パラメータの総数は下記のように概算できます。

上記は$174$Bなので、表の値と概ね一致することが確認できます。

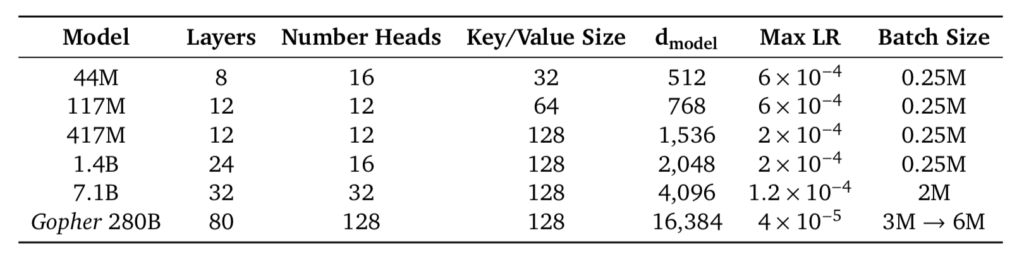

Gopher Gopher論文のパラメータ設定は上記より確認できます。基本的にはGPT$3$と同様にTransformer decoderの構成が用いられます。

$44$M

・Embedding

・Multi-Head Attention

・FFN

よって、パラメータの総数は下記のように概算できます。

上記は$42$Mなので、表の値と概ね一致することが確認できます。

$117$M

・Embedding

・Multi-Head Attention

・FFN

よって、パラメータの総数は下記のように概算できます。

上記は$110$Mなので、表の値と概ね一致することが確認できます。

$417$M

・Embedding

・Multi-Head Attention

・FFN

よって、パラメータの総数は下記のように概算できます。

上記は$389$Mなので、表の値と概ね一致することが確認できます。

$1.4$B

・Embedding

・Multi-Head Attention

・FFN

よって、パラメータの総数は下記のように概算できます。

上記は$1.27$Bなので、表の値と概ね一致することが確認できます。

$7.1$B

・Embedding

・Multi-Head Attention

・FFN

よって、パラメータの総数は下記のように概算できます。

上記は$6.57$Bなので、表の値と概ね一致することが確認できます。

$280B$

・Embedding

・Multi-Head Attention

・FFN

よって、パラメータの総数は下記のように概算できます。

上記は$258$Bなので、表の値と概ね一致することが確認できます。

GLaM

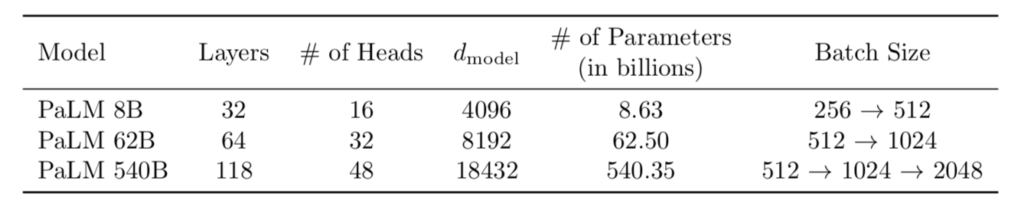

PaLM PaLM論文 Table.$1$ PaLM論文のパラメータ設定は上記より確認できます。基本的にはGPT$3$と同様にTransformer decoderの構成が用いられます。

$8$B

・Embedding

$V=256000$はPaLMの論文を参照しました。

・Multi-Head Attention

・FFN

よって、パラメータの総数は下記のように概算できます。

上記は$7.49$Bなので、表の値$8$Bと概ね一致することが確認できます。

$62$B

・Embedding

・Multi-Head Attention

・FFN

よって、パラメータの総数は下記のように概算できます。

上記は$53.6$Bなので、表の値$62$Bと概ね一致することが確認できます。

$540$B

・Embedding

・Multi-Head Attention

・FFN

よって、パラメータの総数は下記のように概算できます。

上記は$485$Bなので、表の値$540$Bと概ね一致することが確認できます。

参考 ・Transformer論文:Attention is All you need$[2017]$ ・BERT論文 ・T$5$論文 ・GPT$2$論文 ・GPT$3$論文 ・PaLM論文 ・Transformer decoder論文 ・直感的に理解するTransformer(運営者作成)

![データサイエンス数学ストラテジスト[上級]公式問題集](https://m.media-amazon.com/images/I/51-yPvIm0rL._SL500_.jpg)