BERT・GPT-$3$などのTransformerの応用研究を理解するにあたってはEncoder-Decoder、Encoder only、Decoder onlyのようなTransformerの構成の分類を理解しておくと良いです。当記事ではそれぞれの概要や具体的な研究の分類を行いました。

・用語/公式解説

https://www.hello-statisticians.com/explain-terms

Contents

前提の確認

Transformerの仕組み

Dot Product Attentionに主に基づくTransformerの仕組みについては既知である前提で当記事はまとめました。下記などに解説コンテンツを作成しましたので、合わせて参照ください。

Transformerの事前学習

Transformerは強力なモジュールである一方で、大量の学習セットが必要です。そこで予めWikipediaのような巨大なコーパスを元に事前学習(Pre-training)を行なったのちに手元のタスクについてfine-tuningを行うという形式で学習が行われることが多いです。

具体的にはBERT・T$5$・GPT-$3$などの研究が有名です。これらはLLM(Large Language Model)のように総称されることも多く、Transformerの事前学習は昨今の主要なトレンドであると解釈することもできます。

Transformerの構成の分類

概要

Transformerの構成はEncoder-Decoder、Encoder only、Decoder onlyに大別されます。

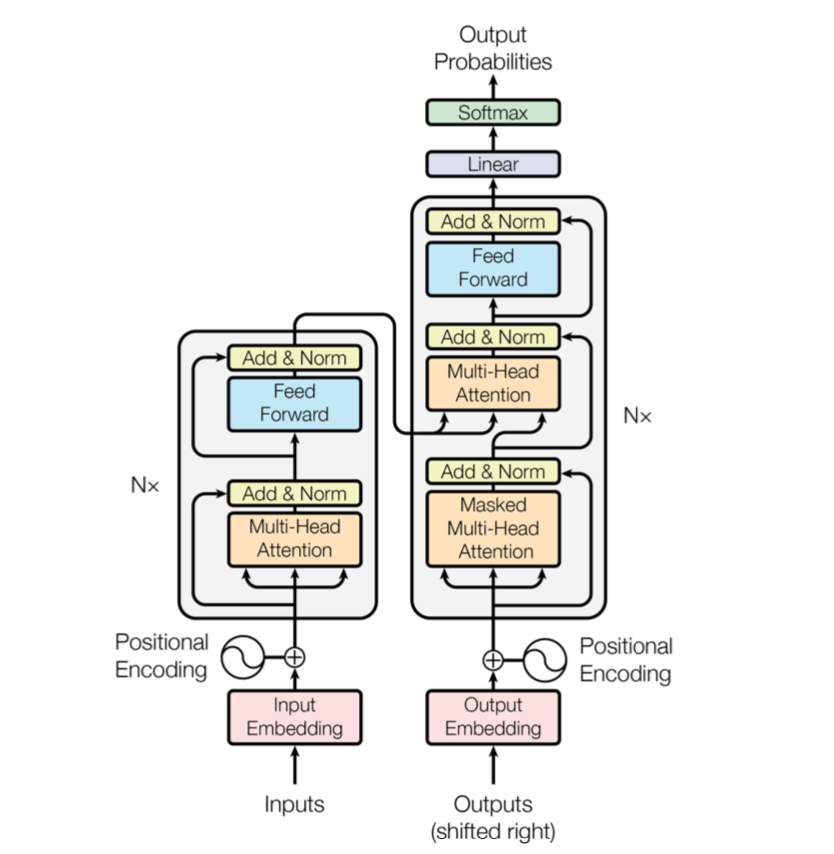

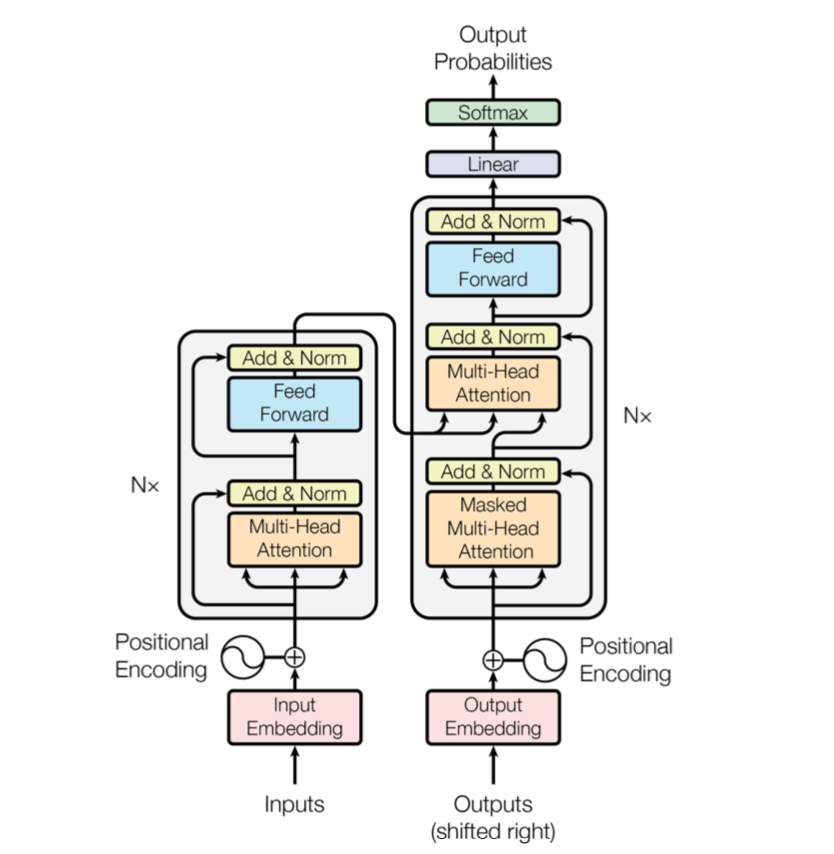

Encoder-Decoder、Encoder only、Decoder onlyはどれもTransformer論文のFigure$\, 1$を元に理解することが可能です。以下、当節ではEncoder-Decoder、Encoder only、Decoder onlyについてそれぞれ詳しく確認を行います。

Encoder-Decoder

「Encoder-Decoder」はオリジナルのTransformerの論文で用いられた形式で、主に系列変換に用いられる構成です。

上図の全体に対応しており、Encoderについて処理したのちにDecoderの処理を行います。このようなEncoder-Decoderの形式はRNNを用いた$2014$年のSequence to sequenceの研究と同様であり、この頃よく取り組まれていたタスクが機械翻訳であることにこの形式は起因すると解釈できます。

Transformerがこの機械翻訳タスクで高いパフォーマンスを示したことで、その後様々な応用研究がなされるようになり、用いられるTransformerの形式も多様化しました。T$5$もEncoder-Decoderの形式であることも合わせて抑えておくと良いと思います。

Encoder only

オリジナルのTransformerがEncoder-Decoderの形式である一方で、Transformerの応用研究で有名なBERTではFine-tuningによって分類タスクを中心に取り扱うことからEncoder onlyの形式が用いられます。

Decoder only

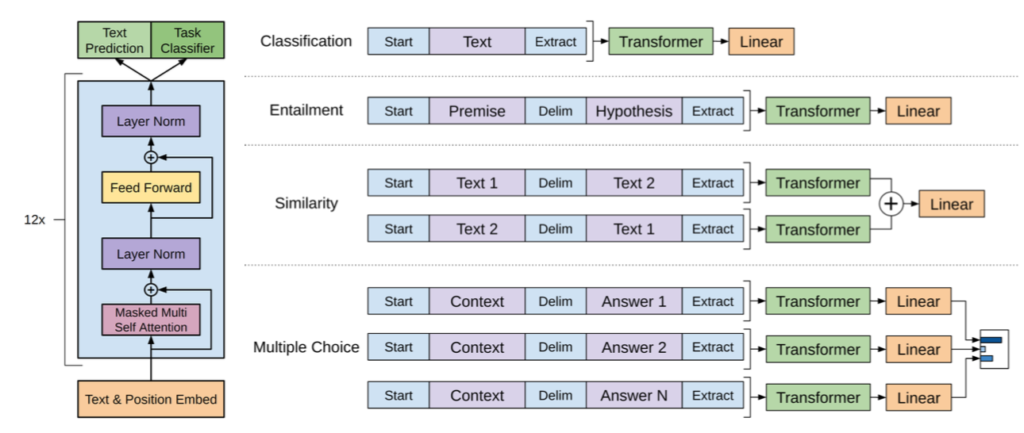

Decoderのみを用いるTransformerはBERTのようなEncoder onlyと反対にDecoderのみを用いて学習を行います。

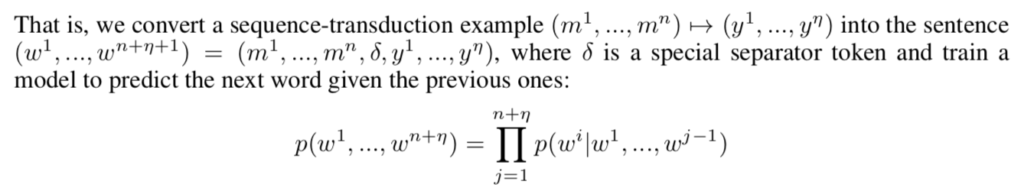

Transformer Decoder論文では上記のような数式に基づいて誤差関数の定義や学習を行いますが、同様のlossはGPT系列でも用いられることからChatGPTやGPT-$4$も概ね同じような構成であることが推測できます。

上図はGPT論文のFigure$\, 1$で、図の左側がTransformerの論文の図のDecoderに一致することが確認できます。

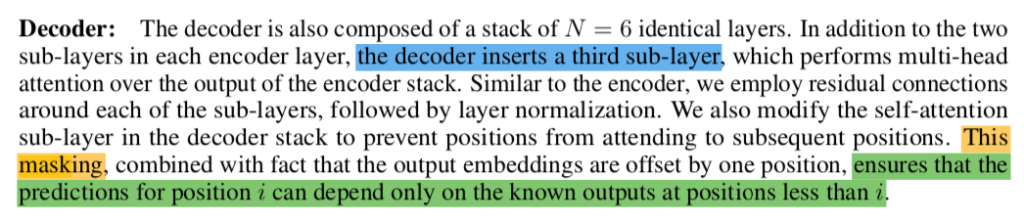

Decoder onlyを理解するにあたって重要になるのがMasked Attention(Transformerの論文の図ではMasked Multi Head Attention、GPT論文の図ではMasked Multi Self Attention)です。

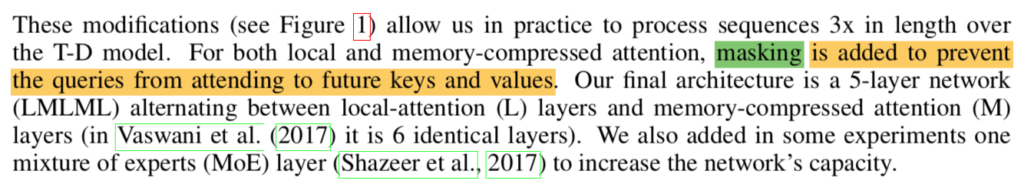

上記はTransformer論文とTransformer Decoder論文のMasked Attentionについての記載です。時系列が逆にならないようにAttentionを計算する際の行列(隣接行列)をマスクすると解釈して良いと思います。

より具体的には対角成分より上の成分が$0$かつそれ以外の成分が$1$である下三角行列を用いてAttentionに用いる行列との要素積を計算すれば自己回帰(Auto Regressive)処理を実現することができます。

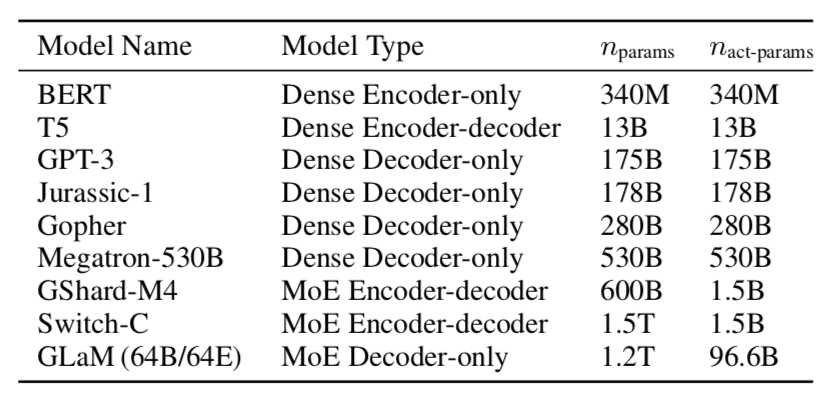

具体的な研究の分類

具体的な研究の分類はGLaM(Generalist Language Model)論文のTable$\, 2$が参考になります。

GPT-$3$以外にもGopherやGLaMでDecoder onlyが用いられることから、LLMの研究ではDecoder onlyが用いられることが多いと解釈して良いと思います。

[…] GPT論文のFigure$1$:左の図がDecoderに基づくアーキテクチャである Transformerの構成の分類:Encoder-Decoder・Decoder onlyなど […]

[…] Transformerの構成の分類:Encoder-Decoder・Decoder onlyなど […]